在現代信息技術架構中,計算機網絡系統集成與數據處理是兩大核心支柱。系統集成旨在將分散的硬件、軟件、網絡組件與數據資源整合為一個協調統一、高效運作的整體系統。而數據處理,作為該系統的“血液”與“智慧”,貫穿于信息采集、傳輸、存儲、分析與應用的全過程。二者深度融合,共同構建了支撐企業運營與業務創新的數字神經中樞。

一、 數據處理在系統集成架構中的關鍵位置

一個典型的集成系統數據處理流程通常遵循“采集-傳輸-存儲-計算-應用”的閉環。

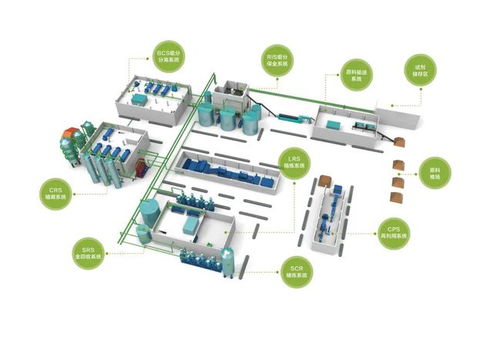

- 數據采集與接入層:集成的首要步驟是打通數據源。這涉及通過物聯網傳感器、業務數據庫API、日志文件、外部數據接口等多種方式,從異構、分布式的終端和設備中實時或批量采集數據。系統集成需要解決不同協議(如MQTT, HTTP, Modbus)、不同格式(結構化、半結構化、非結構化)數據的統一接入與標準化問題。

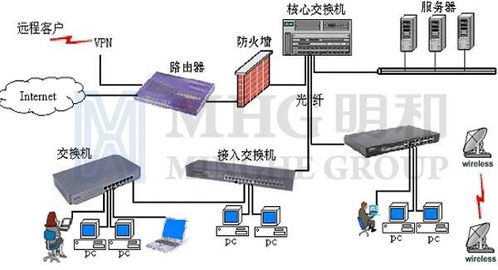

- 網絡傳輸與通信層:這是系統集成的物理與邏輯紐帶。可靠、高速、安全的網絡(如局域網、廣域網、5G專網)負責將采集的數據傳輸至處理中心。集成需優化網絡拓撲,實施負載均衡與流量管理,并確保通過VPN、TLS/SSL等技術保障數據傳輸過程中的機密性與完整性。

- 數據存儲與管理層:集成系統需根據數據特性選擇混合存儲方案。關系型數據庫(如MySQL, PostgreSQL)處理事務性業務數據;NoSQL數據庫(如MongoDB, Redis)應對海量非結構化或高并發訪問;而數據倉庫(如Snowflake, BigQuery)與數據湖則用于整合多源數據,支持歷史分析與挖掘。數據治理(元數據、主數據、數據質量)在此層至關重要。

- 數據處理與計算層:這是數據的“加工廠”。它包含:

- 批處理:對累積的大量數據進行ETL(抽取、轉換、加載),支持離線報表與數據分析。

- 流處理:利用Apache Kafka, Flink, Spark Streaming等技術,對實時數據流進行即時過濾、聚合與響應,滿足監控、預警等場景。

- 智能分析:集成機器學習平臺與算法模型,對處理后的數據進行預測分析、模式識別與深度學習。

- 數據應用與展示層:處理后的數據價值在此釋放。通過集成商業智能(BI)工具、可視化大屏、API服務或直接嵌入業務應用(如ERP、CRM),將數據洞察轉化為決策支持與自動化操作,最終實現業務閉環。

二、 核心挑戰與應對策略

在集成環境中進行高效數據處理面臨諸多挑戰:

- 異構性與兼容性:系統組件來自不同廠商,數據格式與協議千差萬別。應對策略是采用中間件(如ESB企業服務總線)、API網關和制定統一的數據交換標準(如JSON, XML, Avro),實現松耦合集成。

- 數據質量與一致性:多源數據易產生重復、錯誤或不一致。需建立貫穿全流程的數據質量管理體系,包括數據清洗、校驗、血緣追蹤以及在集成初期明確數據所有權與質量標準。

- 實時性要求與系統性能:業務對實時響應的需求日益增長。可通過部署邊緣計算在近數據源處進行預處理以減輕中心壓力,并采用內存計算與高性能網絡來降低延遲。微服務架構有助于分散處理壓力,提高系統彈性。

- 安全與隱私保護:數據在集成網絡中流動,風險點增多。必須實施縱深防御,包括網絡隔離、數據加密(傳輸中與靜態)、嚴格的訪問控制(RBAC)、以及 anonymization 等隱私計算技術,以符合GDPR等法規要求。

- 可擴展性與運維復雜度:數據量增長迅速。采用云原生架構(容器化、Kubernetes編排)與分布式計算框架(如Hadoop, Spark),可以實現資源的彈性伸縮。利用自動化運維(AIOps)工具進行監控、日志分析與故障自愈,降低管理成本。

三、 未來趨勢與優化方向

網絡系統集成與數據處理的融合將向更智能、更自治的方向演進:

- 云邊端協同:數據處理任務將在云中心、邊緣節點和終端設備之間動態分配,實現最優的資源利用與響應效率。

- 數據編織:這是一種新興的架構理念,通過元數據智能驅動,實現跨平臺、跨地域數據的無縫集成、訪問與管理,提升數據發現的敏捷性。

- AI賦能的數據管理:人工智能將深度應用于數據集成本身,例如自動進行模式映射、異常檢測、性能調優與成本優化,實現“智能集成”。

- 增強的數據安全:零信任安全模型、同態加密等先進技術將被更廣泛地集成,確保數據在共享與處理過程中的全程安全。

###

總而言之,在計算機網絡系統集成項目中,數據處理絕非孤立環節,而是與網絡架構、應用系統、安全策略緊密交織的核心能力。成功的集成意味著構建一個既能高效、可靠流動數據,又能深度挖掘數據價值,并具備高度適應性與安全性的有機整體。面對日益復雜的數據環境,唯有堅持架構先行、標準統一、技術融合與持續優化的理念,才能打造出真正驅動數字化轉型的強大引擎。